Luin loppuvuodesta Antti Merilehdon Tekoälyn matkaopas -kirjan ja inspiroiduin. Työkalut ovat kehittyneet kovasti 2000-luvun alusta, jolloin toimin itse Big Data -tutkijana. Silti mielessäni heräsi huoli: tekoälystä puhutaan kovasti, mutta mitä oikeasti tehdään? Mitä analytiikkaprojekteja omalla alallani, työeläkealalla, on menossa? Voisiko tiedon avulla saada ihmiset jaksamaan töissä pidempään?

Törmäsin CGIn Työterveys Virralle, oululaiselle työterveyden palveluyritykselle, toteuttamaan edistyneen analytiikan ja koneälyn ratkaisuun. Se valjastettiin yli 24 000 ihmisen työkyvyn ja hyvinvoinnin parantamiseen. Tekoälyratkaisun avulla työkyvyttömyysriski on tunnistettavissa yli 90 % varmuudella, mikä säästää vuosittain useita satoja henkilötyöpäiviä toimien ennakoivan välittämisen työkaluna.

Jotta riskitapaukset voidaan tunnistaa, pitää koko potilashistoria käydä läpi. Dokumentaatio on hyvin monimuotoista ja sisältää rakenteellista ja numeerista dataa sekä kuvailevaa tekstiä. Jotta tällainen data saataisiin hyödylliseen muotoon, tarvitaan koneälyä, joka käy läpi datan ja nostaa esiin kohonneen riskin yksilöt.

Yhteiskunnallisesti on järkevää, että ihmiset jaksavat terveinä töissä mahdollisimman pitkään ja yksilönkin kannalta kuormittavat työkyvyttömyyseläkejaksot vältetään

Tämä on minusta kiinnostava esimerkki datan hyödyntämisestä. Yhteiskunnallisesti on järkevää, että ihmiset jaksavat terveinä töissä mahdollisimman pitkään ja yksilönkin kannalta kuormittavat työkyvyttömyyseläkejaksot vältetään. Uskon myös, että mahdollisimman varhainen puuttuminen on avainasemassa, jolloin yksilön työkykyyn on vielä mahdollista vaikuttaa.

Dataa on eri organisaatioissa valtavasti. Tyypillisesti sitä kertyy yrityksen eri toiminnoista: myynnistä ja asiakkuuden hoidosta omanlaistaan, vakuutus- ja ratkaisujärjestelmistä omanlaistaan. Data jää helposti organisaation siilojen vangiksi: kukin näkee vain oman yksikkönsä datan. Voisiko kuitenkin olla hyödyllistä, että data virtaisi organisaation prosessien läpi päästä päähän ja rikastuisi matkalla lisäten ymmärrystä asiakkaan tilanteesta?

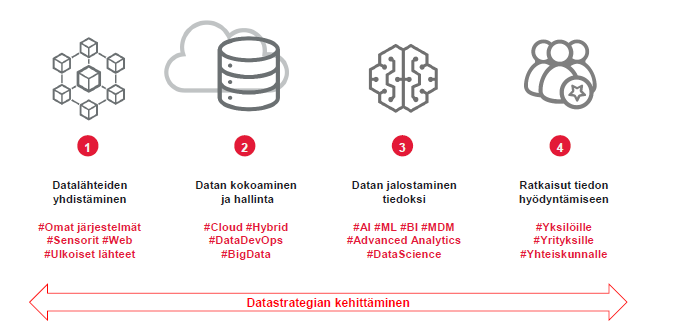

CGI:llä on käytössä nelivaiheinen malli analytiikan hyödyntämisestä:

Ensimmäisessä vaiheessa käydään läpi yrityksen data. Mitä kaikkea tietoa meille on kertynyt? Mistä kaikkialta sitä löytyy? Tyypillisesti data on eri järjestelmien syövereissä ja eri tietomalleissa, joten sen hyödyntäminen on haastavaa. Ensimmäisen kartoituksen jälkeen saadaan kuitenkin kokonaiskuva yrityksen tietovarastoista. Tietoa kerääntyy myös koko ajan: datan keruu on yrityksen tuntosarvet ympäröivään maailmaan.

Seuraavassa vaiheessa käydään dataan käsiksi. Tarkoitus on saada yhdisteltyä tietoa ja rikkoa organisaation siilot, joita kuvailin aiemmin. Dataa voidaan taltioida pilviratkaisuihin, mutta kannattaa myös pitää mielessä hybridiratkaisut, joissa osa tiedosta halutaan säilyttää yrityksen omissa tietovarastoissa tietoturvasyistä. Data on keskiössä myös DevOpsissa, ketterän kehittämisen mallissa, jossa IT ja liiketoiminta tekevät kiinteää yhteistyötä, jotta muutoksiin voidaan reagoida mahdollisimman nopeasti.

Kun organisaation datasta on saatu käsitys, on aika ideoida. Ideointiin olisi hyvä saada mukaan ihmisiä organisaation eri puolilta – jokaisella on varmasti vähän erilainen näkemys siitä, mitä meidän pitäisi saada selville. Haluammeko vastata paremmin asiakkaiden tarpeisiin? Haluammeko lisätä myyntiä, tai kenties parantaa asiakastyytyväisyyttä? Tekoälyn ja koneoppimisen työkaluja on iso joukko, mutta jotta pääsemme hyödyntämään niitä, pitää meidän tietää, mitä etsimme ja mihin haluamme vastauksia.

Ja kun tiedämme, mitä etsimme, löydämme varmasti ratkaisuja. Case Virta on esimerkki ratkaisusta, joka hyödyntää yksilöä, yritystä ja koko yhteiskuntaa. Lisätietoa Case Virrasta.

Tutustu myös

- Blogi: Rakkaudesta dataan – strategia antaa tarvittavat rajat

- Mitä on tekoäly?

- Työeläkevakuuttamisen palvelumme

Ota askelia kohti tehokkaampaa toimintaa, uusia palveluja ja parempaa asiakaskokemusta ja -ymmärrystä CGI:n analytiikka- ja tekoälytyöpajoissa.