Zij die verantwoordelijk zijn voor digitale systemen bij de overheid hebben onvoldoende aandacht voor de ethische aspecten van die systemen. Dat is één van de conclusies uit het recente rapport ‘Aandacht voor algoritmes’ van de Algemene Rekenkamer, die de impact van het gebruik van algoritmes op de samenleving onderzocht. Wie dragen die verantwoordelijkheid? Misschien komt het niet dagelijks voor dat we een ontwerpbeslissing nemen met merkbare ethische gevolgen. Maar de impact van dat soort beslissingen kan zodanig groot zijn dat we maar beter voorbereid kunnen zijn als ze toch onze kant op komen. In dit blog laat ik hiervan een aantal voorbeelden zien en deel ik enkele bruikbare hulpmiddelen.

Waarom gaat dit ons aan?

Wacht even – waarom zou ik me hier druk om moeten maken als gewone IT’er? Is dat wel mijn rol? Moet ik kwesties van moraliteit en wettelijkheid niet overlaten aan politici en filosofen? Als mijn baas mij vraagt iets te doen dat mogelijk onethisch is, heb ik dan niet de plicht zijn opdracht uit te voeren zolang het niet illegaal is?

Nou, nee. Er zijn technici die vanwege een ontwerpbeslissing achter de tralies zijn beland. Zoals Volkswagen-architect James Liang. De sjoemelsoftware die Liangs team ontwikkelde brak in Europa strikt genomen geen wetten, maar in sommige staten in de VS wel. Hij belandde uiteindelijk in de cel en mocht daar een straf uitzitten van 40 maanden voor zijn rol in het schandaal.

Een ander voorbeeld is Ruchi Sanghvi, wiens verhaal verteld wordt door Clive Thompson in ‘Coders’. Sanghvi is de ontwikkelaar van de allereerste versie van het algoritme dat bepaalt welke berichten je te zien krijgt als je Facebook opent. Dit algoritme groeide in tien jaar uit van een onschuldige vriendenfunctie tot een polariserend monster dat mensen een fabeltjesfuik inlokt, familievetes ontketent en uiteindelijk het politieke landschap wereldwijd doet verkleuren.

Lang niet alle digitale ontwerpbeslissingen hebben natuurlijk zulke wereldschokkende gevolgen als het dieselschandaal en de Facebook-bubbel. Deze gevallen zijn echter maar het topje van de ijsberg als het gaat om de ethische impact. De algoritmes die onze systemen gebruiken worden steeds ingewikkelder en ondoorzichtiger. Dat komt onder andere door de toenemende ketenintegratie, maar ook door het steeds meer en makkelijker inzetten van Machine Learning en andere vormen van Artificial Intelligence. Het gebeurt zowel bij de overheid (bijvoorbeeld bij het bepalen van je WOZ-waarde) als in het bedrijfsleven (denk aan risicoanalyses bij leningen).

De voorbeelden hierboven laten goed zien dat je op ieder niveau in het digitale voortbrengingsproces ethische impact kan hebben, of je nu product owner, architect, ontwikkelaar of UX-ontwerper bent (zie Trine Falbe’s ‘White Hat UX’). Dus ja, het gaat ons IT’ers allemaal aan.

Sjoemelsofware

James Liang leidde het team dat software ontwikkelde voor dieselmotoren. Die ‘sjoemelsoftware’ leidde uit een aantal factoren (zoals snelheid in combinatie met gebruik van het stuur) af of een auto op de weg of in een testlab reed. Als de software detecteerde dat de auto in een testlab stond werden de motorinstellingen zodanig aangepast dat de uitstoot van schadelijke stoffen omlaag ging. Dit ging ten koste van de prestaties, en daarom werden de standaardinstellingen hersteld zodra de auto op de weg reed. Bij normaal gebruik overschreed de auto dan ook ruimschoots de uitstootnormen.

Wat kunnen we eraan doen?

Een steeds groter wordende groep onderzoekers en instellingen heeft zich de laatste jaren gebogen over de vraag hoe we de negatieve maatschappelijke impact van digitale systemen beter kunnen beheersen. Dit heeft geleid tot een aantal nuttige instrumenten:

- Het boekje ‘De Digitale Kooi’ van de Kafka-brigade laat heel duidelijk zien hoe een zekere blindheid voor ethiek in de informatiearchitectuur van de overheid voor bepaalde burgers desastreuze gevolgen heeft. De auteurs laten het overigens niet bij treurige cases. Ze presenteren ook een mooie lijst van tien architectuurprincipes voor behoorlijk digitaal bestuur. Wat mij betreft zouden die principes letterlijk moeten worden overgenomen in de Nederlandse Overheid Referentie Architectuur (NORA).

- Het rapport ‘Aandacht voor algoritmes’ van de Algemene Rekenkamer bevat een toetsingskader om de kwaliteit en verantwoorde inzet van algoritmes in de praktijk te kunnen beoordelen. Ethiek speelt in dit model een centrale rol, waaraan een reeks van 63 risico’s in vier categorieën wordt gekoppeld aan zeven ethische principes.

- ethicstoolkit.ai is een raamwerk voor risicobeheersing voor overheden. Het raamwerk benadert het soms wat wollige onderwerp ‘ethiek’ als een risicobeheersingsprobleem en geeft zo handvatten die voor de meeste organisaties vertrouwd overkomen. Daardoor is het makkelijk in te passen in bestaande processen. Daar waar het hierboven genoemde toetsingskader van de Algemene Rekenkamer vaak slechts vermeldt wát je kunt doen om ethiek-gerelateerde risico’s te beheersen, geeft de Ethics Toolkit ook zeer bruikbare tips over het hóe van die maatregelen.

- De EU heeft een ‘Trustworthy AI Assessment Checklist’ samengesteld waarmee je zelf de impact van algoritmes op het welzijn van maatschappij en omgeving kan toetsen op eerlijkheid, verantwoording, transparantie, veiligheid, privacy en de menselijke maat. Deze checklist is de basis geweest voor de zeven ethische principes in het toetsingskader van de Algemene Rekenkamer.

- Voor diegenen die betrokken zijn bij het ontwerp van digitale systemen is er de ‘Design for Values’-aanpak van een groep geleid door de TU Delft. De aanpak helpt je om de vertaling van ethische normen en waarden naar systeemeigenschappen expliciet te maken. Dit is nodig om een open discussie te kunnen voeren over de interpretatie en prioritering van ethische waarden in het systeemontwerp.

Ethisch raamwerk Algemene Rekenkamer

- 1. Respect voor menselijke autonomie

- 1.1 De beslissingen die gemaakt zijn door het algoritme zijn te controleren door menselijke tussenkomst.

- 2. Voorkomen van schade

- 2.1 Het algoritme is veilig en doet altijd waarvoor het gemaakt is.

- 2.2 Privacy is gewaarborgd en data zijn beschermd.

- 3. Fairness (een eerlijk algoritme)

- 3.1 Het algoritme houdt rekening met diversiteit in de populatie en discrimineert niet.

- 3.2 Er is bij de ontwikkeling van het algoritme rekening gehouden met impact op maatschappij en milieu.

- 4. Verklaarbaarheid en transparantie

- 4.1 Er kan verantwoording worden afgelegd over de gevolgde procedures.

- 4.2 De werking van het algoritme is te verklaren en uit te leggen.

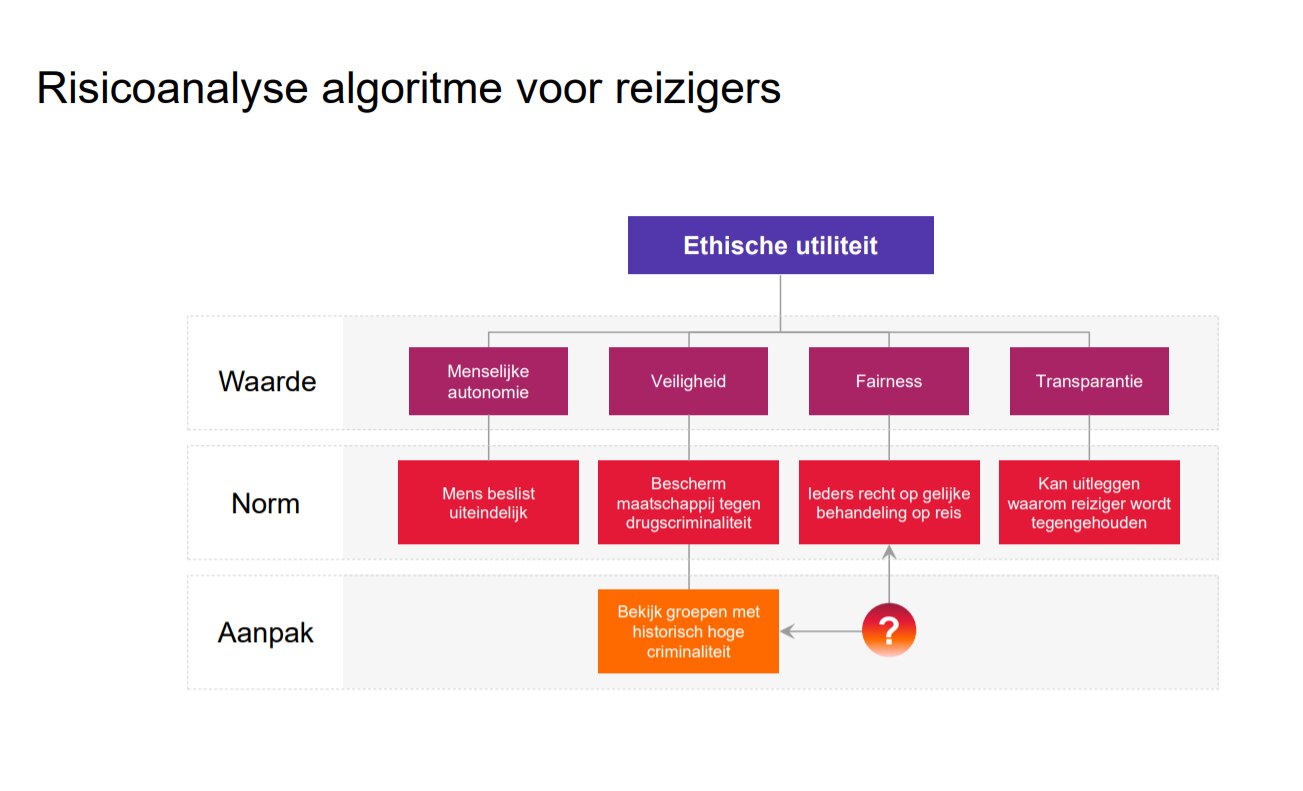

Werk aan de winkel

We hebben vanuit de architectuur-practice bij CGI de afgelopen jaren veel aandacht besteed aan het onderwerp ethiek. Dit heeft geleid tot een aantal interessante workshops (onder andere bij de Vrije Universiteit en onlangs nog met de Koninklijke Marechaussee), waar we op basis van de bovengenoemde instrumenten de focus op ethiek handen en voeten hebben gegeven. Een voorbeeld is het gevoelige onderwerp van het profileren van reizigers aan de grens. Onderstaande figuur combineert het ethisch raamwerk van de Algemene Rekenkamer met de ‘Design for Values’-aanpak, toegepast op een systeem van risicoanalyse op basis van groepen met een historisch hoge betrokkenheid bij illegale activiteiten. Het model legt haarfijn bloot dat zo’n systeem weliswaar te verdedigen is op basis van de ethische waarde ‘veiligheid’, maar dat diezelfde maatregel de waarde ‘eerlijkheid’ mogelijk geweld aandoet, omdat de mensen die toevallig tot een risicogroep behoren moeilijker de grens kunnen passeren. Dat is natuurlijk nog maar het begin van de discussie (welke ethische waarde weegt zwaarder, en hoe kan/moet een algoritme daarmee omgaan?), maar het is een eerste hoopvolle stap naar betere inzichten en betere systemen – die rekening houden met de menselijk maat.