Die wichtigsten Themen dieses Blog-Artikels:

- Welche Vorteile bieten spezialisierte LLMs für Versicherungen?

- Wie funktioniert die semantische Suche bei Underwriting-Dokumenten?

- Welche Produkte eignen sich für Versicherungen am besten?

- Welche Rolle spielen Datenschutz und Regulatorik beim Einsatz von LLMs?

- Welche Risiken und Herausforderungen bringt der Einsatz von LLMs mit sich?

- Chancen und Nutzen von LLMs im Underwriting – ein Fazit

Im Rahmen des Underwritings werden bei Versicherungsunternehmen regelmäßig Bestandsauswertungen durchgeführt. In der Regel ist dies mit großem manuellem Aufwand verbunden – beispielsweise bei Renewals, Sanktionsprüfungen und ESG-bezogenen Aufgaben. Dies liegt vor allem daran, dass in den Bestandssystemen von Versicherungen die Daten oft nur im Textformat vorliegen. In diesem Blog-Artikel beschreibe ich, welche Vorteile künstliche Intelligenz und insbesondere Large Language Models (LLMs) bei der Analyse und dem Durchsuchen großer Mengen von Bestandsdokumenten bieten und welche Effizienzgewinne sich damit im Underwriting realisieren lassen.

Welche Vorteile bieten spezialisierte LLMs für Versicherungen?

Large Language Models (LLMs) gehören zur Kategorie der generativen KI (GenAI) und werden eingesetzt, um Texte zu verstehen und zu generieren. Auf Grundlage der Daten, mit denen sie trainiert wurden, sind sie in der Lage, das nächste Wort vorherzusagen, das in einem gegebenen Kontext mit größter Wahrscheinlichkeit folgt. Am Ende entsteht als Resultat ein Text.

Größere Basis-Modelle, auch Foundation Models genannt, werden in der Regel von großen Tech-Unternehmen entwickelt und zur Verfügung gestellt, da ihr Training mit hohen Kosten verbunden ist. Bekannte Beispiele hierfür sind GPT von OpenAI, Gemini von Google oder Claude von Anthropic. Die breit gefächerte Trainingsgrundlage sorgt dafür, dass bereits die Basis-Modelle mit den meisten Aufgaben und Anfragen zuverlässig umgehen können.

Wenn der konkrete Aufgabenbereich eines Large Language Models bereits vorab bekannt und klar abgegrenzt ist, kann es sich meiner Erfahrung nach aber auch empfehlen, auf ein kleineres, spezialisiertes Modell zurückzugreifen. So gibt es beispielsweise feinjustierte LLMs, die besonders gut Informationen extrahieren oder Texte klassifizieren können. Darüber hinaus birgt die Wahl eines spezialisierten Modells entscheidende Vorteile für Versicherungen, z. B. niedrigere Compute-Kosten und einen geringeren Ressourcenverbrauch.

Dennoch können beide Varianten – große Generalisten und kleine Spezialisten – bei der Bearbeitung von Bestandsdokumenten im Underwriting zum Einsatz kommen und die Arbeitsprozesse hier entscheidend vereinfachen.

Wie funktioniert die semantische Suche bei Underwriting-Dokumenten?

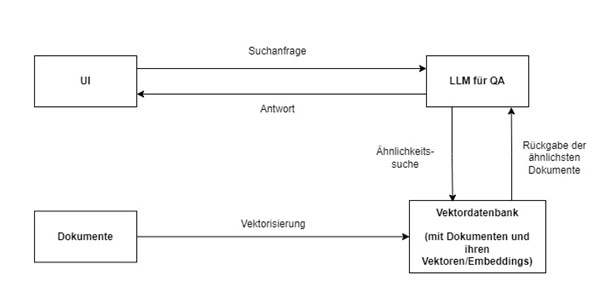

Eine typische Anwendung ist die semantische Suche in Policen und Bestandsdokumenten. Hierbei steht dem Nutzenden, z. B. der Underwriterin oder dem Underwriter bzw. der Bestandsmanagerin oder dem Bestandsmanager, ein Eingabefeld in einem User Interface (UI) zur Verfügung. Die eingegebene Suchanfrage wird in einen Prompt für das LLM übersetzt. Im Hintergrund greift das LLM dann auf eine Vektordatenbank zu, in der die Dokumente sowohl im Originalformat als auch in vektorisierter Form, d. h. in einem numerischen Format, gespeichert sind.

Die Vektordarstellung ermöglicht es, Inhalte nicht nur auf Wortebene, sondern auch semantisch, also inhaltlich, miteinander zu vergleichen. Die Nutzeranfrage wird dafür in das gleiche numerische Vektorformat überführt. Anschließend erfolgt eine Ähnlichkeitssuche – anhand der Distanz der Vektoren zueinander. Vektoren mit einer geringeren Distanz zueinander gelten dabei als ähnlicher als solche, die weiter voneinander entfernt sind. Auf Grundlage dieser Suche wird durch die Applikation eine Liste von Dokumenten bereitgestellt, die nach Relevanz sortiert ist.

Grafik 1: Semantische Suche mit vektorisierten Dokumenten

Wie die Grafik zeigt, erfolgt die Suchanfrage vom UI aus an das LLM, das nach passenden Dokumenten und ihren Vektoren bzw. Embeddings in der Vektordatenbank sucht. Von dieser erfolgt die Rückgabe der ähnlichsten Dokumente zurück an das LLM, das daraus wiederum eine Antwort ans UI formuliert.

Welche Produkte eignen sich für Versicherungen am besten?

Versicherungsunternehmen stehen verschiedene Tools zur Verfügung. Plattformen wie HuggingFace bieten eine Vielzahl frei verfügbarer Modelle und Datensätze, die sich per API integrieren lassen. OpenAI stellt hingegen leistungsstarke LLMs wie GPT gegen Bezahlung bereit.

Für komplexere Anwendungen mit Dialogfunktion, Kontextspeicherung oder mehrstufigen Abfragen empfehle ich Frameworks wie LangChain oder LlamaIndex. Sie ermöglichen u. a. die Verknüpfung von LLMs mit externen Vektor- und Graphdatenbanken, wodurch aktuelle, spezialisierte Datenquellen eingebunden werden können. Diese Methode wird auch als Retrieval Augmented Generation (RAG) bezeichnet. Dabei müssen relevante Informationen nicht im Modell selbst gespeichert sein, sondern können zur Laufzeit abgerufen werden.

Für Vektordatenbanken bieten sich etwa chromadb, Pinecone oder die pg-vector-Erweiterung von PostgreSQL an; für netzwerkartige Beziehungen rate ich gerne zu Neo4j als Beispiel für eine Graphdatenbank. Bei ESG- und Renewal-Prozessen lassen sich zum Beispiel vektorisierte Textinhalte in einer chromadb-Datenbank lagern und an das gewünschte LLM anreichen. Im Falle von Sanktionsprüfungen ist es meiner Erfahrung nach am sinnvollsten, eine Graphdatenbank wie Neo4j zu nutzen, da Netzwerke sanktionierter Akteure hiermit besser nachvollzogen werden können.

Welche Rolle spielen der Datenschutz und die regulatorischen Anforderungen beim Einsatz von LLMs?

In der Versicherungsbranche spielen Datenschutz und regulatorische Anforderungen eine zentrale Rolle. In Deutschland unterliegt die Verarbeitung personenbezogener Daten der Datenschutz-Grundverordnung (DSGVO) und muss daher besonders transparent und sicher erfolgen. Versicherungsunternehmen haben daher die Pflicht, sicherzustellen, dass die eingesetzten LLMs mit den vorgegebenen Datenschutzstandards kompatibel sind – besonders bei einer Zusammenarbeit mit Cloud-Anbietern.

Das bedeutet unter anderem:

- Sie benötigen klare Regelungen zur Datenverarbeitung (Data Processing Agreements).

- Wenn sensible Daten verarbeitet werden, müssen ggf. On-Premises-Modelle eingesetzt werden.

- Es müssen Maßnahmen zur Anonymisierung oder Pseudonymisierung von Daten ergriffen werden.

- Die Möglichkeit zur Auditierung und Nachvollziehbarkeit von Entscheidungen ist obligatorisch.

Zusätzlich sind in Deutschland Vorgaben von Aufsichtsbehörden wie der BaFin zu berücksichtigen. Dazu gehört u. a. VAIT (Versicherungsaufsichtliche Anforderungen an die IT). Hierin wird eine eindeutige Governance für KI-Systeme gefordert. Darüber hinaus muss nach den VAIT die Verantwortung für die Entwicklung, den Betrieb und die Überwachung der Systeme an konkrete Ansprechpartner übergeben werden.

Auf ähnliche Weise setzt DORA (Digital Operational Resilience Act) auf EU-Ebene voraus, dass Risiko- und Schwachstellenanalysen durchgeführt und Probleme gemeldet werden. Ebenfalls auf EU-Niveau soll der European AI Act dafür sorgen, dass KI-Systeme in einem EU-Register angemeldet werden und dass die Kundinnen und Kunden – z. B. beim Einsatz von KI im Underwriting – über diesen Prozess informiert sind. Allen Regelwerken liegt zugrunde, dass die Integration von KI-basierten Systemen zur Entscheidungsfindung so gestaltet werden muss, dass sie nachvollziehbar bleibt und der Benutzer die finale Entscheidungshoheit behält.

Welche Risiken und Herausforderungen bringt der Einsatz von LLMs mit sich?

Trotz des großen Potenzials von LLMs gibt es auch kritische Faktoren, die in der Praxis unbedingt beachtet werden sollten:

- Halluzinationen: LLMs können plausible, aber faktisch falsche Aussagen erzeugen – insbesondere, wenn sie ohne externe Datenquellen agieren.

- Abhängigkeit von Drittanbietern: Bei der Nutzung kommerzieller APIs und des Ökosystems eines Drittanbieters kann es schwierig werden, den Prozess oder Teile davon nachträglich auf vergleichbare Weise mit alternativen Werkzeugen zu betreiben.

- Kosten: Die laufenden Kosten für API-Zugriffe oder Rechenleistung können bei hoher Skalierung schnell steigen.

- Erklärbarkeit: Viele LLMs agieren als Black-Box, was in stark regulierten Branchen problematisch sein kann.

- Fachkräftemangel: Die Integration von LLMs in bestehende Prozesse und Systeme erfordert Spezialwissen, das in vielen Unternehmen noch nicht ausreichend vorhanden ist.

Ein verantwortungsvoller Umgang mit diesen Herausforderungen erfordert transparente Entwicklungsprozesse, manuelle Kontrollmechanismen und ein regelmäßiges Monitoring der Modelle. Führt eine fehlerhafte KI-Empfehlung beispielsweise dazu, dass ein Antrag auf Versicherungsschutz zu Unrecht abgelehnt oder mit falschen Konditionen versehen wird, sollte es etablierte Prozesse zur Überprüfung und Korrektur solcher Entscheidungen geben. Im besten Fall wird dies durch die manuelle Kontrolle der KI-Ausgabe durch eine Underwriterin oder einen Underwriter bereits im Vorfeld erkannt und korrigiert.

Chancen und Nutzen von LLMs im Underwriting – ein Fazit

Large Language Models bieten Versicherungsunternehmen wertvolle Möglichkeiten, um wiederkehrende und textlastige Aufgaben im Underwriting deutlich effizienter zu gestalten. Besonders in Kombination mit semantischer Suche, Vektordatenbanken und Retrieval Augmented Generation lassen sich relevante Informationen schnell und zuverlässig aus umfangreichen Dokumentenbeständen extrahieren.

Damit der Einsatz von LLMs jedoch erfolgreich ist, müssen neben der Technologie auch Fragen rund um den Datenschutz, die Erklärbarkeit und die Regulierung berücksichtigt werden. Ein strukturierter Einführungsprozess, beginnend mit einem Pilotprojekt, bietet sich daher an. So können die Risiken minimiert und konkrete Mehrwerte frühzeitig aufgezeigt werden: zum Beispiel eine deutliche Reduktion manueller Prüfaufwände oder eine höhere Trefferquote bei kritischen Prüfungen.

Richtig eingesetzt sind LLMs ein zukunftsfähiges Werkzeug im modernen Underwriting – effizient, lernfähig und auf lange Sicht unverzichtbar.

Sie möchten mehr über dieses Thema erfahren? Sprechen Sie mich gerne an!