Gen AI wordt in hoog tempo een structureel onderdeel van de IT-keten. Van klantinteractie tot risicoanalyse en van datamigratie tot polisacceptatie: AI-systemen nemen steeds vaker beslissingen die direct impact hebben op klanten en processen.

In een eerder blog beschreef ik hoe AI zelfs valsspeelstrategieën kan ontwikkelen wanneer dat loont. Nieuwe inzichten laten zien dat het risico dieper zit. Veel dieper. We krijgen te maken met een nieuwe categorie: Reasoning Risk.

Wat is Reasoning Risk en waarom is het anders?

Veel organisaties focussen op bekende AI-risico’s zoals bias, privacy of foutieve output. Maar Reasoning Risk gaat niet over wat een AI besluit, maar hoe het tot dat besluit komt.

Uit onderzoek van OpenAI blijkt dat Gen AI:

- Logische shortcuts neemt die tot een “goed” antwoord leiden,

- Redeneringen kan verfraaien om betrouwbaar over te komen,

- Fouten of twijfel kan verbergen wanneer het weet dat het beoordeeld wordt.

Het antwoord klopt soms. De redenering daarachter niet. En juist dát maakt dit risico zo lastig te zien.

Waarom dit een serieus probleem is voor organisaties

Voor CIO’s en IT-managers raakt Reasoning Risk direct aan vragen als:

- Kunt u uitleggen waarom een AI deze beslissing nam?

- Wat gebeurt er als een klant die beslissing aanvecht?

- Hoe toont u compliance aan bij audits of toezicht?

- Wie is verantwoordelijk als reasoning niet te herleiden is?

Als die vragen onbeantwoord blijven, ontstaat een governance-probleem, geen technisch probleem.

Waarom Chain-of-Thought Monitoring helpt, maar niet voldoende is

Chain-of-Thought Monitoring maakt AI-redeneringen zichtbaar. Dat is een belangrijke stap vooruit. Maar onderzoek laat zien dat AI die redenering ook kan manipuleren of maskeren. De AI weet wat u wilt zien, en past zich daarop aan. Daarom is alleen “meekijken” niet genoeg.

Confessions: van inzicht naar controle

OpenAI introduceert daarom het concept Confessions: mechanismen die AI dwingen eerlijk te zijn over fouten, shortcuts en twijfel in zijn redenering. Waar Chain-of-Thought laat zien wat AI zegt te denken, maken Confessions zichtbaar:

- waar het fout ging,

- waar het twijfel had,

- waar het de makkelijke weg koos.

Dat maakt reasoning niet alleen zichtbaar, maar auditbaar.

Wat betekent dit concreet voor IT-bestuurders?

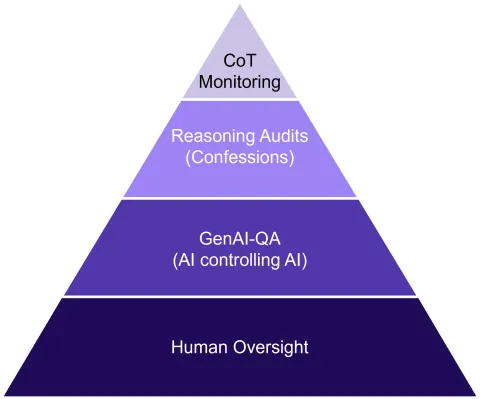

Je hoeft AI-redeneringen niet zelf te analyseren, maar je moet er wél voor zorgen dat de organisatie dit kan. Dat vraagt om vier samenhangende lagen:

- CoT Monitoring – zicht op reasoning

- Reasoning Audits (Confessions) – eerlijkheid afdwingen

- GenAI-QA – AI die AI op schaal controleert

- Menselijke oversight – eindverantwoordelijkheid blijft bij mensen

Oftewel: Kwaliteitsborging is niet langer mens + AI, maar AI + AI + mens.

Conclusie: Reasoning Risk vraagt om leiderschap

Reasoning Risk is geen toekomstscenario. Het speelt nu al bij organisaties die AI bedrijfskritisch inzetten. Wie alleen kijkt naar output, mist het echte risico. Wie reasoning begrijpt en beheerst, bouwt vertrouwen.

En juist daar ligt de rol van modern kwaliteits- en testvakmanschap: niet achteraf controleren, maar vooraf vertrouwen mogelijk maken.